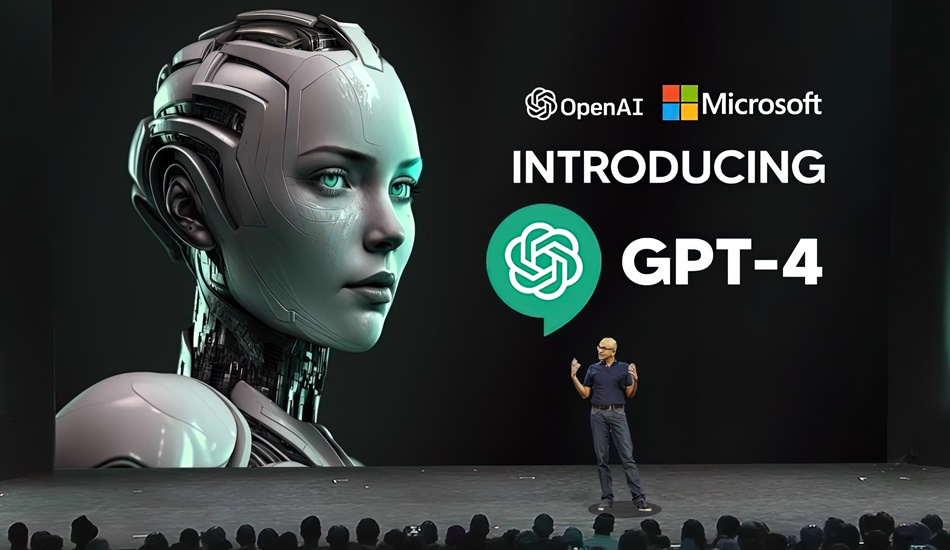

OpenAI выпустила новую усовершенствованную модель ИИ для понимания изображений и текста GPT-4. Компания называет свою разработку последней вехой в своих усилиях по расширению глубокого машинного обучения.

GPT-4 способен работать с текстом и изображениями, хотя на выходе он по-прежнему выдает информацию в формате текстовых сообщений.

– В случайном разговоре различия между GPT-3.5 и GPT-4 могут быть незначительными. Разница проявляется, когда сложность задачи достигает достаточного порога – GPT-4 более надежен, креативен и способен обрабатывать гораздо более тонкие инструкции, чем GPT-3.5, – говорится в сообщении OpenAI.

GPT-4 доступен для платных пользователей OpenAI через ChatGPT Plus. Разработчики могут зарегистрироваться в списке ожидания для доступа к API. Цена составляет $0,03 за 1000 токенов–подсказок (около 750 слов).

Корпорация Microsoft подтвердила, что Bing Chat, созданный совместно с OpenAI, уже работает на GPT-4.

GPT-4 может генерировать текст на основе изображений и сообщений. Здесь виден явный прогресс. Предшественник GPT-3.5 принимал только текст.

– Например, если пользователь отправит фотографию внутренней части своего холодильника, нейросеть не только правильно определит, что в нем изображено, но и проанализирует, что можно приготовить из этих ингредиентов. Инструмент также может предложить несколько рецептов и отправить пошаговое руководство по их приготовлению.

Среди других ранних пользователей Stripe, которая использует GPT-4 для сканирования бизнес-сайтов и предоставления сводки сотрудникам службы поддержки клиентов. Duolingo встроил алгоритм в новый уровень подписки для изучения языков. Morgan Stanley создает систему на базе GPT-4, которая будет извлекать информацию из документов компании и предоставлять ее финансовым аналитикам.

Стало известно, что OpenAI и Microsoft применяли суперкомпьютер в облаке Azure для обучения GPT-4.